Wie funktioniert ein Large Language Modell?

Vielleicht hast du schon mal von ChatGPT, GPT-4 oder anderen KI-Modellen gehört und dich gefragt, wie diese Systeme funktionieren. Diese Modelle gehören zu einer Kategorie namens Large Language Models (LLMs), die gerade die Welt erobern, von Chats über Übersetzungen bis hin zu kreativen Texten. Doch wie funktionieren sie genau? In diesem Blogartikel erkläre ich dir verständlich und anschaulich, was hinter den Kulissen passiert und was ein Large Language Modell wirklich ist.

Was genau ist ein Large Language Modell?

Ein Large Language Modell, kurz LLM, ist ein computergestütztes Modell, das darauf trainiert wurde, menschliche Sprache zu verstehen, zu generieren und sogar darauf zu reagieren. Im Kern handelt es sich dabei um riesige künstliche neuronale Netze, die Milliarden Parameter besitzen. Diese Modelle lernen aus gigantischen Textmengen aus Büchern, Artikeln, Webseiten und Foren, um Sprache so gut wie möglich zu verstehen und selbständig Texte zu erstellen.

Stell dir ein LLM wie ein unglaublich umfangreiches und komplexes „Gehirn“ vor, das sich aus Milliarden kleiner Verbindungen („Neuronen“) zusammensetzt. Diese Neuronen werden beim Training so optimiert, dass das Modell lernt, Texte zu erzeugen, die Sinn ergeben, Zusammenhänge aufzeigen und auf deine Fragen logisch antworten können.

Der Aufbau eines Large Language Modells

Um zu verstehen, wie ein LLM funktioniert, solltest du zunächst wissen, was neuronale Netze sind.

Was sind neuronale Netze?

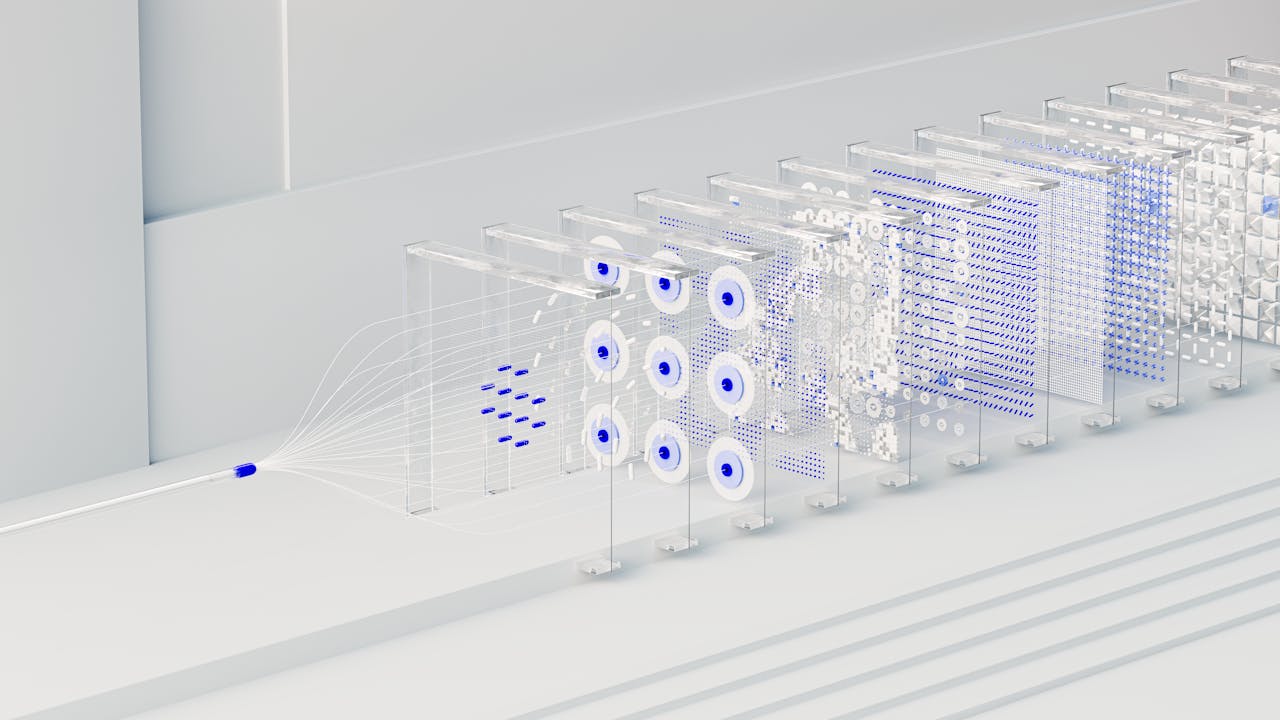

Neuronale Netze sind von biologischen Nervenzellen inspiriert. Sie bestehen aus sogenannten Neuronen, die in Schichten organisiert sind:

- Eingabeschicht: Hier wird die Eingabe, z. B. deine Frage, vom Modell aufgenommen.

- Versteckte Schichten: Diese Schichten verarbeiten die Eingabe und erkennen Muster sowie Bedeutungen.

- Ausgabeschicht: Hier wird die Ausgabe, z. B. die Antwort auf deine Frage, generiert.

LLMs verwenden oft spezielle Arten neuronaler Netze namens Transformer-Netzwerke, da diese besonders gut darin sind, Zusammenhänge innerhalb grosser Texte zu verstehen und zu erzeugen.

Der Transformer – das Herzstück moderner Sprachmodelle

2017 revolutionierte ein bahnbrechendes Paper namens „Attention Is All You Need“ die Welt der KI. Es führte die sogenannte Transformer-Architektur ein, die heute in fast allen modernen LLMs wie GPT-3, GPT-4 oder ChatGPT steckt.

Ein Transformer-Netzwerk zeichnet sich durch zwei wichtige Komponenten aus:

- Self-Attention-Mechanismus: Hier lernt das Modell, welche Wörter in einem Satz besonders wichtig sind und wie sie miteinander zusammenhängen.

- Positionale Kodierung: Das Modell weiss dank einer speziellen Technik, an welcher Stelle ein Wort im Satz steht, um die Bedeutung richtig zu interpretieren.

Stell dir vor, du liest einen Satz und betonst instinktiv wichtige Wörter stärker. Genau das macht ein Transformer automatisch. Er entscheidet, worauf er seine Aufmerksamkeit richtet, um den Sinn des Satzes besser zu verstehen.

Wie lernt ein Large Language Modell?

Um leistungsfähig zu sein, benötigt ein LLM enorme Mengen an Textdaten, die das Modell nutzt, um zu lernen, wie Sprache funktioniert.

1. Training auf riesigen Datenmengen

Ein typisches LLM wie GPT-4 wurde mit Hunderten Milliarden Wörtern trainiert. Dazu zählen Inhalte aus:

- Büchern

- Wikipedia-Artikeln

- Webseiten

- Nachrichtenartikeln

- Foren und sozialen Medien (z. B. Reddit)

- Fachliteratur

Dabei „liest“ das Modell riesige Textmengen und versucht, Muster zu erkennen. Zum Beispiel lernt es, dass nach dem Satz „Heute ist das Wetter sehr schön und die Sonne scheint“ oft Sätze folgen, die positiv und fröhlich sind. Das Modell lernt diese Zusammenhänge durch unzählige Beispiele kennen.

2. Vorhersagen und Optimierungen

Während des Trainings bekommt das Modell immer wieder einen Textabschnitt und muss das nächste Wort oder den nächsten Satz vorhersagen. Anfangs sind diese Vorhersagen eher schlecht, doch mit jedem Durchlauf werden die Verbindungen („Gewichte“) in den neuronalen Netzen optimiert, um die Vorhersagen immer genauer zu machen.

Dieser Optimierungsprozess nennt sich Backpropagation (zu Deutsch „Rückwärtspropagierung“). Dabei berechnet das Modell seinen Fehler und korrigiert anschliessend die Gewichte der Neuronen entsprechend. Nach Milliarden solcher Durchläufe entsteht schliesslich ein Modell, das erstaunlich genaue und sinnvolle Texte produzieren kann.

3. Finetuning (Feinabstimmung)

Nachdem das Modell auf allgemeinen Daten trainiert wurde, erfolgt oft eine sogenannte Feinabstimmung auf spezielle Aufgaben oder Themen. Beispielsweise kann ein LLM speziell für medizinische Fragen oder kreative Schreibaufgaben weitertrainiert werden. Durch das Finetuning erhält das Modell besondere Fähigkeiten in einem bestimmten Bereich.

Wie erzeugt ein Large Language Modell Antworten?

Nachdem ein LLM trainiert wurde, kann es auf Anfragen reagieren und eigenständig Texte erzeugen. Doch wie genau funktioniert dieser Prozess?

Schritt 1: Verarbeitung der Eingabe (Prompt)

Wenn du dem Modell eine Frage stellst, nennt man diesen Textabschnitt einen Prompt. Das Modell verarbeitet den Prompt Wort für Wort. Der Prompt gibt dem Modell wichtige Hinweise darüber, was als Nächstes kommen könnte.

Schritt 2: Wahrscheinlichkeiten berechnen

Das Modell analysiert daraufhin mögliche nächste Wörter oder Sätze und berechnet für jedes mögliche Wort eine Wahrscheinlichkeit. Zum Beispiel könnte es erkennen, dass auf „Guten Morgen, wie geht“ wahrscheinlich „es dir?“ folgt.

Schritt 3: Textgenerierung

Das Modell wählt nun das Wort mit der höchsten Wahrscheinlichkeit oder eines aus mehreren möglichen aus, um den Satz fortzuführen. Dieser Prozess wiederholt sich Schritt für Schritt, Wort für Wort, bis eine vollständige Antwort entsteht.

Hierbei kommt häufig eine Technik namens Temperatursteuerung zum Einsatz. Sie beeinflusst, wie kreativ oder konservativ die Antwort ausfällt:

- Niedrige Temperatur: Die Antwort ist konservativ, vorhersehbar und oft sicher.

- Hohe Temperatur: Die Antwort ist kreativer, aber möglicherweise weniger genau.

Herausforderungen und Grenzen eines Large Language Modells

Trotz ihrer beeindruckenden Fähigkeiten haben LLMs ihre Grenzen und Herausforderungen.

1. Kein echtes „Verständnis“

Obwohl die Texte, die LLMs produzieren, oft sinnvoll wirken, besitzen diese Modelle kein echtes Verständnis von Inhalten oder menschlichen Erfahrungen. Sie kennen die Bedeutung von Wörtern nicht wirklich, sondern berechnen lediglich statistische Zusammenhänge.

2. Halluzinationen – Wenn das Modell fantasiert

Manchmal generieren LLMs Inhalte, die falsch oder erfunden sind, sogenannte Halluzinationen. Dies geschieht vor allem dann, wenn das Modell eine Frage beantworten soll, zu der es nicht genug Wissen hat. Statt dann zuzugeben, dass es etwas nicht weiss, erfindet es manchmal eine Antwort, die zwar plausibel klingt, aber inhaltlich falsch ist.

3. Biases – Verzerrungen und Vorurteile

LLMs lernen aus Texten, die Menschen geschrieben haben. Deshalb können sie menschliche Vorurteile (Biases) übernehmen. So könnte ein Modell zum Beispiel unbewusst stereotype Antworten liefern, wenn die Trainingsdaten entsprechende Tendenzen enthalten.

Wie werden Large Language Modelle genutzt?

Die Einsatzmöglichkeiten von LLMs sind vielfältig und wachsen stetig:

- Chatbots (wie ChatGPT): Beantwortung von Nutzerfragen in Echtzeit.

- Texterstellung: Kreative Texte, Artikel, Blogposts, Gedichte oder Geschichten.

- Übersetzungen: Texte in verschiedene Sprachen übersetzen.

- Textzusammenfassungen: Lange Texte verständlich zusammenfassen.

- Programmieren: Generierung und Korrektur von Programmcode.

- Wissensmanagement: Schneller Zugriff auf Wissen und automatisierte Informationsverarbeitung.

Zukunft der Large Language Modelle

Die Entwicklung geht rasant weiter. Zukünftige Modelle könnten noch leistungsfähiger werden und neue Funktionen wie Multimodalität (Verarbeitung von Bildern, Sprache und Text gleichzeitig) entwickeln.

Allerdings stellt uns diese Technologie auch vor gesellschaftliche und ethische Herausforderungen, etwa in Bezug auf Datenschutz, Urheberrecht und Transparenz.

Fazit

Large Language Modelle sind faszinierende technische Errungenschaften, die Sprache in bisher unerreichter Qualität generieren und verstehen können. Ihr Geheimnis liegt in gigantischen neuronalen Netzen, Transformer-Architekturen und riesigen Trainingsdatenmengen.

Doch trotz ihrer beeindruckenden Fähigkeiten bleibt eines klar: Ein LLM versteht Sprache anders als Menschen – nämlich über Statistik und Mustererkennung, nicht über echtes Verständnis.

Wir stehen erst am Anfang einer spannenden Reise mit dieser Technologie, und die nächsten Jahre dürften noch viele Überraschungen bereithalten.